OpenAI, le créateur de ChatGPT, a finalement dévoilé sa nouvelle technologie GPT-4 capable d’accepter des entrées de texte et d’image.

Après quelques semaines de rumeurs, OpenAI vient enfin d’annoncer son dernier modèle de langage IA baptisé GPT-4. Ce dernier alimente déjà des applications comme ChatGPT Plus et le nouveau chatbot IA du moteur de recherche Bing. L’entreprise d’intelligence artificielle affirme que ce nouveau modèle, qui peut analyser du texte et des images, est « plus créatif et collaboratif que jamais » et qu’il « peut résoudre des problèmes difficiles avec une plus grande précision ».

OpenAI GPT-4 : un système plus performant et multimodal

Announcing GPT-4, a large multimodal model, with our best-ever results on capabilities and alignment: https://t.co/TwLFssyALF pic.twitter.com/lYWwPjZbSg

— OpenAI (@OpenAI) March 14, 2023

OpenAI indique avoir déjà conclu des partenariats avec un certain nombre d’entreprises pour incorporer GPT-4 dans leurs produits. Ce nouveau modèle IA est d’ores et déjà accessible via l’abonnement ChatGPT Plus, ainsi que le chatbot IA de Microsoft Bing. Il sera également prochainement accessible aux développeurs sous la forme d’une API.

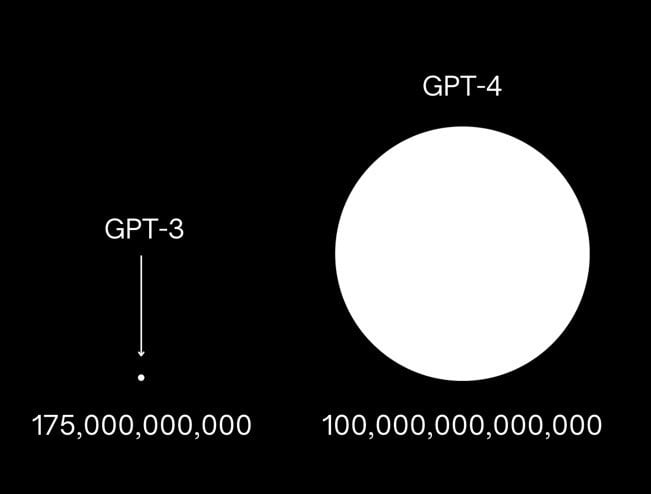

Sur son blog, OpenAI indique que la distinction entre GPT-4 et son prédécesseur GPT-3.5 est « subtile » dans une conversation ordinaire. GPT-3.5 est le modèle IA intégrer à la version grand public et gratuite de ChatGPT. Selon l’entreprise d’intelligence artificielle, les améliorations apportées par GPT-4 sont évidentes dans les performances du système sur un certain nombre de tests et de benchmarks. Néanmoins, OpenAI nuance ses propos en indiquant que les systèmes conservent bon nombre de défauts rencontrés par les modèles IA antérieurs, notamment une tendance à présenter avec assurance des informations fausses ou inventées.

Toutefois, la grosse nouveauté du modèle IA GPT-4 est qu’il est multimodal. OpenAI indique que le GPT-4 peut accepter des entrées de texte et d’image et émettre des résultats en texte. La société précise que la capacité du modèle IA à analyser simultanément le texte et l’image lui permet d’interpréter des données plus complexes.

En outre, lors de l’annonce de GPT-4, OpenAI a souligné que le système avait fait l’objet d’un entraînement de six mois en matière de sécurité et que, lors de tests internes, il était « 82 % moins susceptible de répondre à des demandes de contenu non autorisé et 40 % plus susceptible de produire des réponses factuelles que le modèle GPT-3.5 ».

Cependant, cela ne signifie pas que le système ne commet pas d’erreurs ou ne produit pas de contenu préjudiciable. De plus, GPT-4 n’a toujours pas connaissance des événements qui se sont produits après septembre 2021.